El nuevo chip de SambaNova está diseñado para funcionar con modelos IA de 5 billones de parámetros

por Jordi BercialDesde que OpenAI lanzó ChatGPT a finales del año pasado, términos como Inteligencia Artificial generativa y grandes modelos de lenguaje han estado en boca de todos, pero si profundizamos en las exageraciones, los modelos de lenguajes grandes generalmente requieren de GPUs de altísimo rendimiento para funcionar.

SambaNova ha presentado hoy un chip que, según afirma, reducirá significativamente ese coste, al tiempo que maneja un modelo de 5 billones (5 trillones americanos) de parámetros. Puede que SambaNova no sea un nombre familiar como Google, Microsoft o Amazon, pero ha estado creando una solución de inteligencia artificial completa que incluye hardware y software durante varios años.

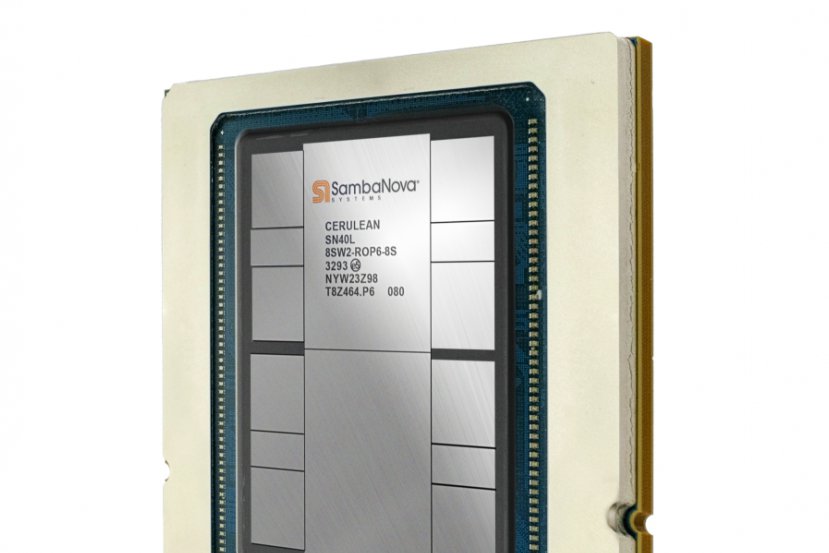

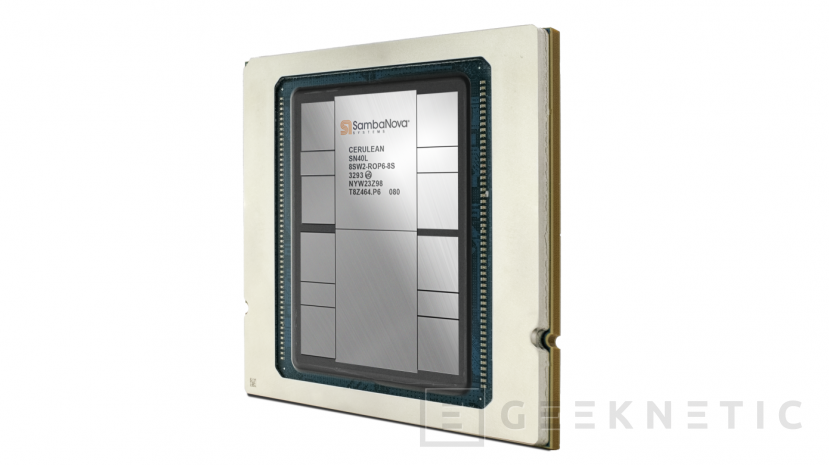

Hoy, la compañía presentó su último chip, el SN40L, la cuarta generación de sus chips de IA personalizados internos. El fundador y director ejecutivo de la empresa, Rodrigo Liang, dice que la idea detrás de la construcción de sus propios chips es controlar el hardware subyacente para lograr la máxima eficiencia, y es que Liang dice que sus nuevos chips son 30 veces más eficientes al reducir la cantidad de chips necesarios para alimentar estos modelos.

De hecho, afirma que ejecutar el mismo modelo de un billón de parámetros en chips de la competencia requeriría entre 50 y 200 chips, mientras afirma que SambaNova lo ha reducido a sólo 8 chips. “¿Cuántos recursos se necesitan para ejecutar un modelo de un billón de parámetros como un GPT-4? Puedo hacerlo en ocho sockets, puedo entregarlo localmente y puedo entregarlo completamente optimizado en ese hardware, y se obtiene una precisión de vanguardia”, dijo.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!

ESCRÍBE UN NUEVO COMENTARIO ¿Qué opinas sobre este tema? ¿Alguna pregunta?

Se enviará como Anónimo.