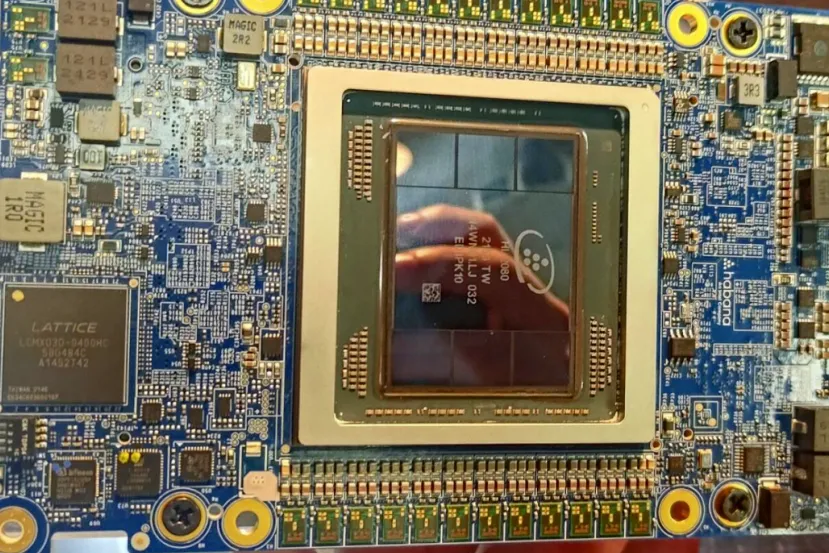

La tarjeta aceleradora de IA Intel Gaudi 2 con 96 GB HBM2E promete ser la única alternativa a la NVIDIA H100

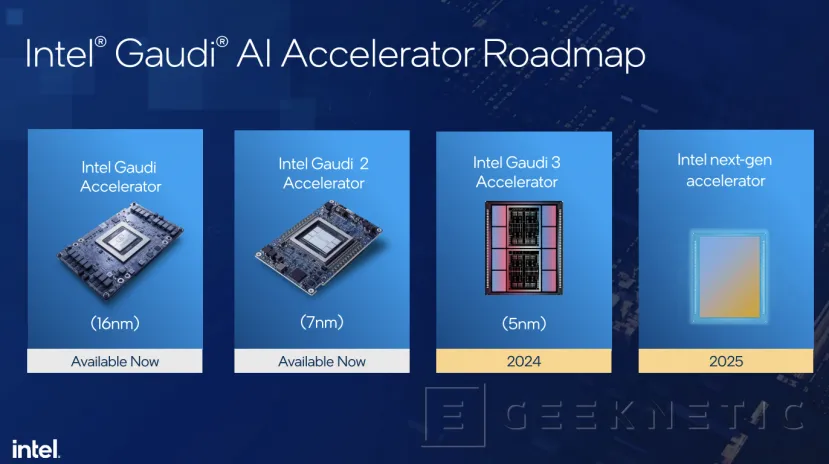

por Antonio Delgado Actualizado: 14/12/2023Además de los procesadores Intel Xeon de Quinta Generación "Emerald Rapids", Intel también nos ha mostrado en su evento dedicado a sus novedades de hardware para IA, detalles sobre sus tarjetas aceleradoras Gaudi 2, ya disponibles, y la llegada de las Gaudi 3 para el próximo año 2025.

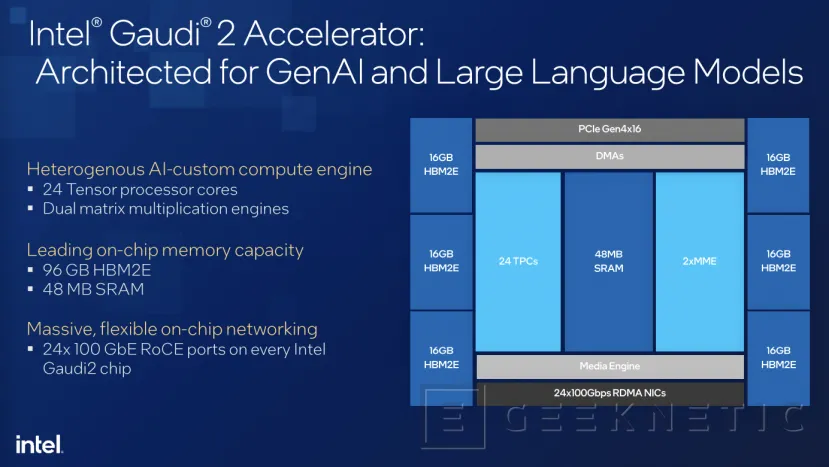

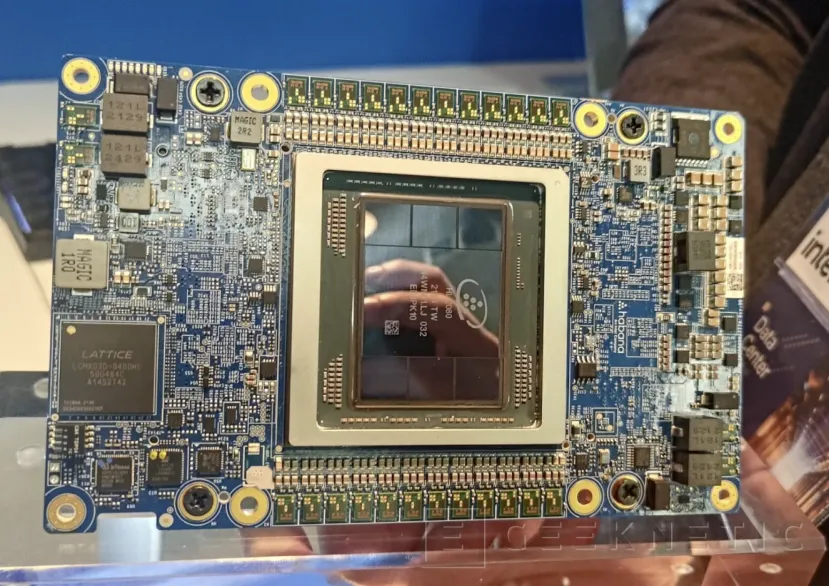

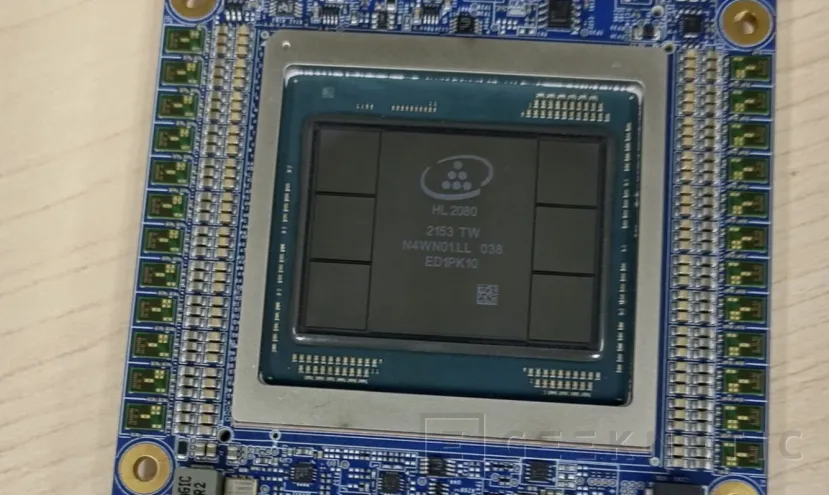

El modelo más reciente disponible de las línea de tarjetas aceleradoras para procesos de inferencia y Deep Learning de Inteligencia artificial es la Gaudi 2, una tarjeta creada específicamente para estas tareas y dotada de 24 Tensor Cores junto a 96 GB de memoria HBM2E.

Va acompañada de una matriz dual de motores de multiplicación y 48 MB de memoria SRAM, además de contar con 24 puertos de 100 GbE en cada chip para gestionar la transferencia de datos a gran velocidad entre esta tarjeta y el resto del hardware.

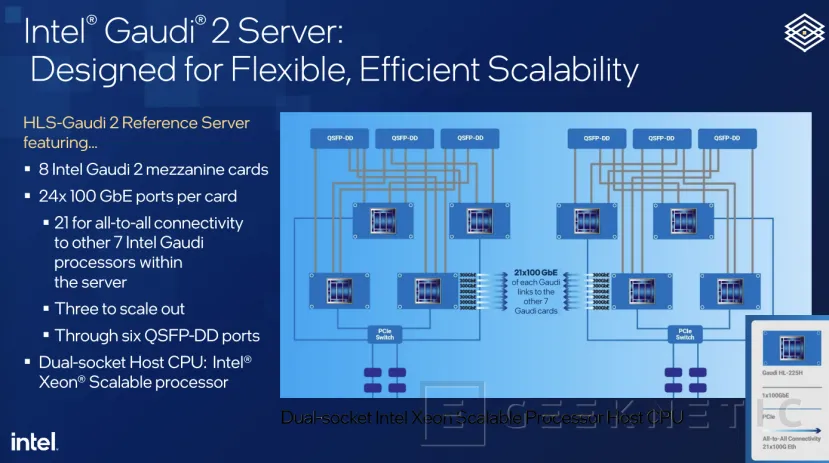

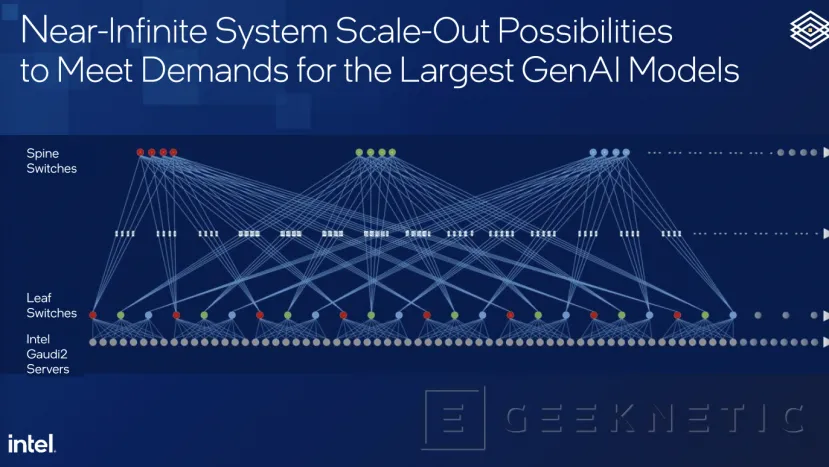

La tarjeta se ha diseñado para conseguir una escalabilidad teórica prácticamente infinita, gracias a sus 24 puertos de 100 GbE, se pueden interconectar multitud de estas tarjetas entre sí junto a un servidor formado por procesadores Intel Xeon Scalable de doble socket.

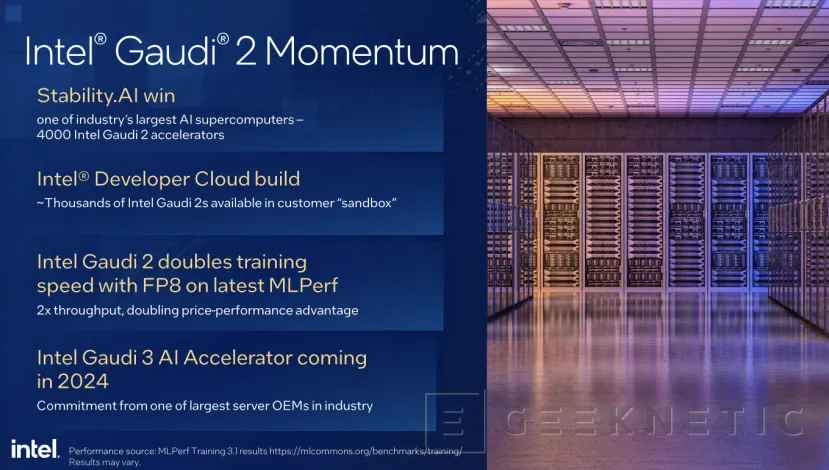

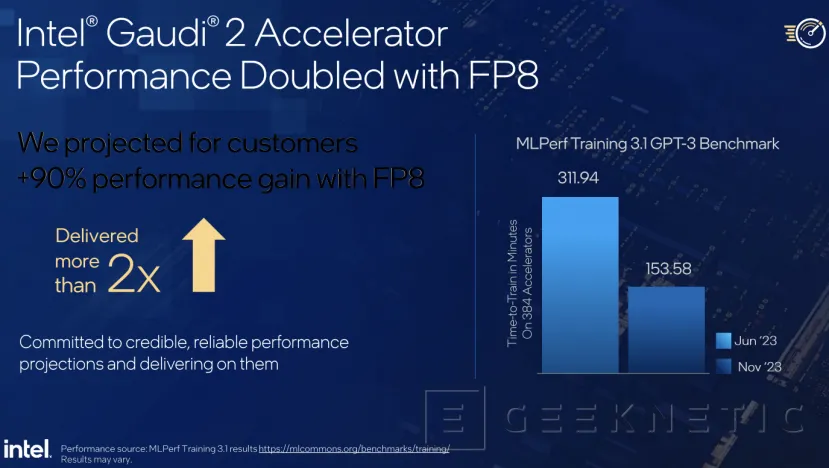

Gaudi 2 consigue doblar el rendimiento en MLPerf FP8 , y ya está disponible para integradores de supercomputadores de todo el mundo. De hecho, uno de los más potentes del mundo integra 4.000 tarjetas aceleradoras Intel Gaudi 2 en sus instalaciones.

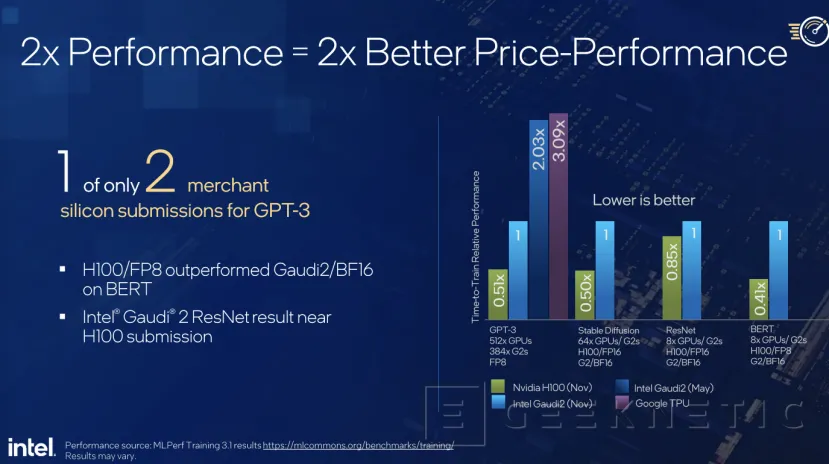

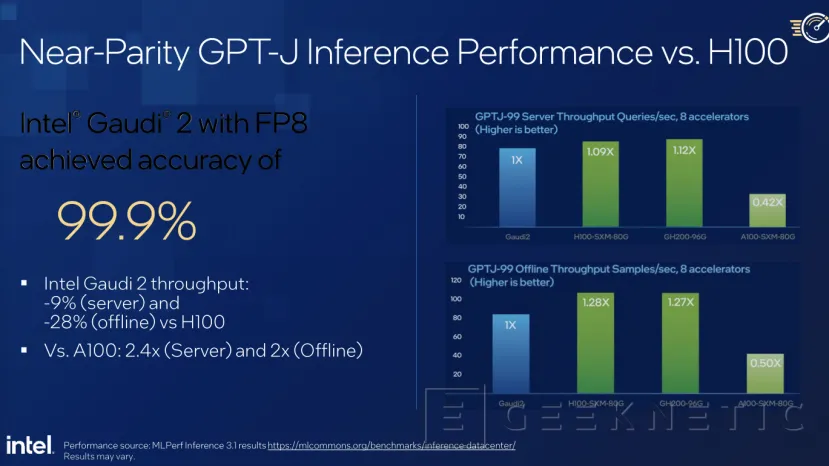

De hecho, Intel asegura que es la única alternativa a la NVIDIA H100 para Inteligencia Artificial Generativa, consiguiendo un rendimiento superior con una relación del doble de precio/rendimiento en tareas como GPT o Stable Difussion. Y consiguiendo casi el mismo rendimiento, o muy similar, a la H100 en GPT-J.

Esto se debe a la evolución de rendimiento que Intel ha conseguido desde mayo hasta ahora, duplicando el rendimiento de su tarjeta Gaudi 2.

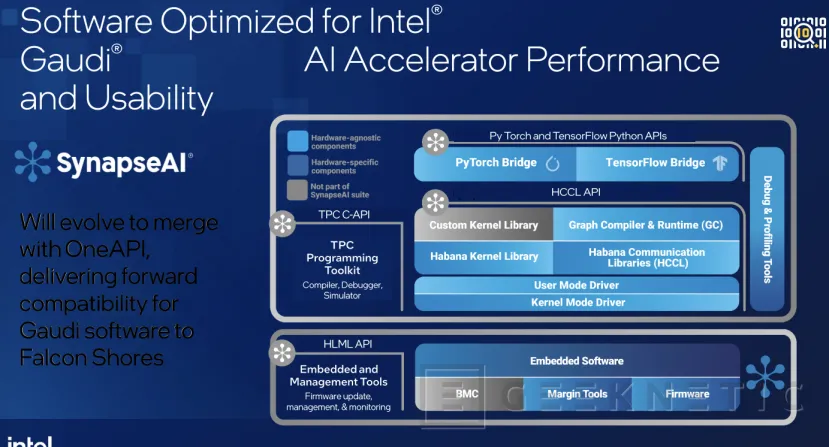

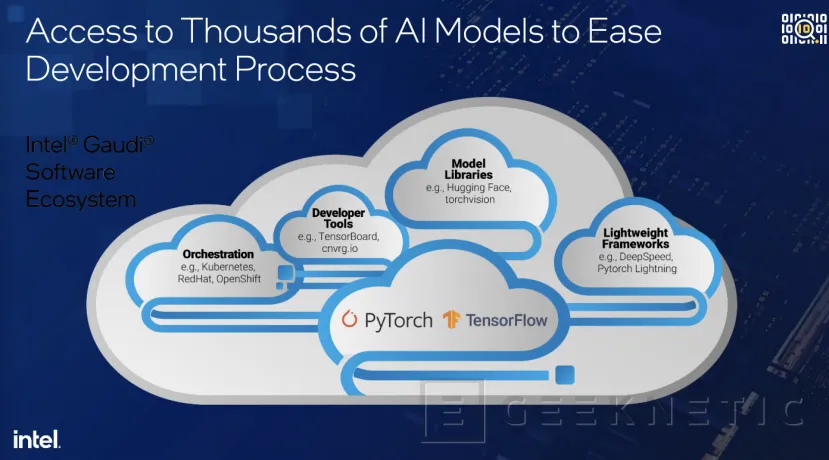

Todo ello se combina con la plataforma de software de Intel y un ecosistema con distintos tipos de herramientas de desarrollo, soporte para PyTorh y TensorFlow, y todo tipo de tecnologías directamente disponibles para los desarrolladores.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!