Así de fácil puedes Instalar DeepSeek en Local en tu Ordenador

por Edgar Otero Actualizado: 04/02/2025¿Se puede ejecutar DeepSeek en local?

En esta guía te explico cómo ejecutar los modelos de DeepSeek en local. Todo lo que te voy a explicar funciona gracias a Ollama, un programa que se ejecuta a través de la consola de comandos y que permite interactuar con cualquier modelo de lenguaje que sea de código abierto.

Antes de poner manos a la obra, es necesario que descargues y ejecutes Ollama, ya sea en Windows, macOS o Linux. Yo voy a seguir los pasos desde un Mac, pero aquí tienes una guía donde se explica cómo instalar y configurar Ollama en tu PC Windows.

El Mac que voy a emplear es el MacBook Air M2 con 8 GB de RAM y 256 GB de almacenamiento interno. Como ves, no se trata de un equipo con una gran fuerza bruta, pero que es capaz de lidiar con las versiones 7b y 8b, que son dos de las más pequeñas. Si tienes un equipo más potente, te explico cómo instalar los modelos más grandes y, de este modo, contar con mayor capacidad de procesamiento. Por otro lado, no te olvides de echar un vistazo a los mejores trucos de DeepSeek.

Todos los modelos de DeepSeek compatibles con Ollama

Ollama te permite ejecutar de forma local los modelos de la startup china DeepSeek. Actualmente, dispone de los dos más potentes. Por un lado, está DeepSeek-V3, un modelo similar a GPT-4o y, por el otro, DeepSeek-R1, un modelo de razonamiento similar a OpenAI o1. También cuenta con el resto de los modelos de la startup china, aunque, sin duda, estos dos son los más interesantes.

Una vez que hayas instalado y configurado Ollama, abre la línea de comandos. Si quieres ejecutar DeepSeek-V3, lanza el siguiente comando:

- ollama run deepseek-v3

Ten en cuenta que DeepSeek-V3 tiene una única versión con 671 billones de parámetros (671b). Ocupa 404 GB, así que se trata de un modelo gigantesco. No solo vas a necesitar mucho espacio en tu PC, sino que también será necesaria una enorme cantidad de recursos.

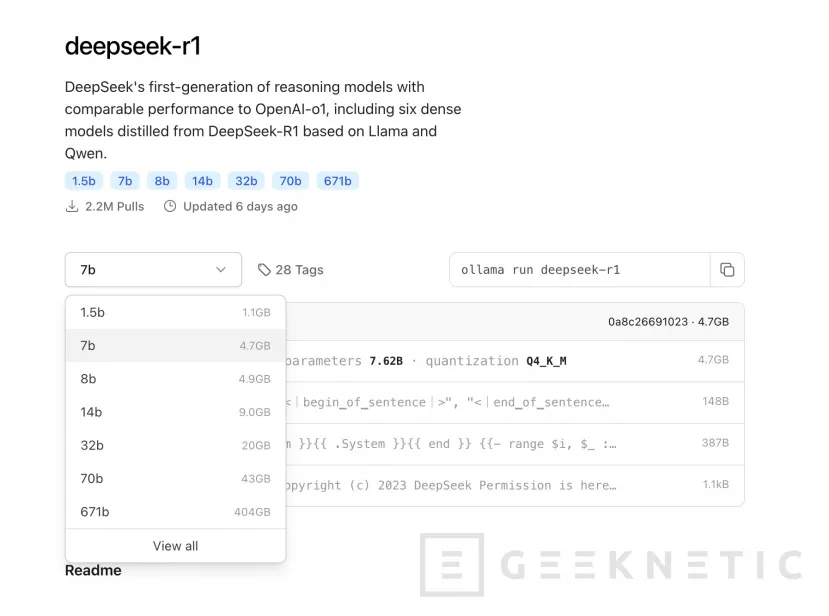

Con DeepSeek-R1 la cosa es distinta. Este modelo cuenta con varias versiones, que parten de un modelo bastante reducido, 1.5b, hasta alcanzar un tamaño enorme, 671b. Lo bueno es que por el camino también tienes versiones 7b y 8b que son perfectamente funcionales en la mayoría de los equipos.

Para descargar el modelo y empezar a usarlo con Ollama, ejecuta este comando:

- ollama run deepseek-r1

Este comando descarga el modelo predeterminado, que es 7b. Visita la página de DeepSeek-R1 en Ollama para elegir el modelo que prefieras. Al hacerlo, obtendrás el comando necesario para ejecutar cada uno de los modelos.

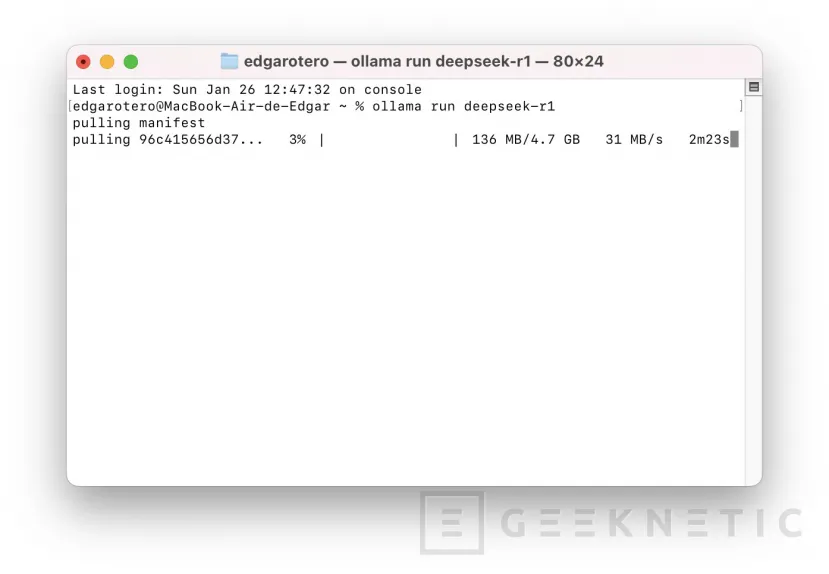

Una vez que hayas ejecutado el comando, espera a que se descargue el modelo de DeepSeek.

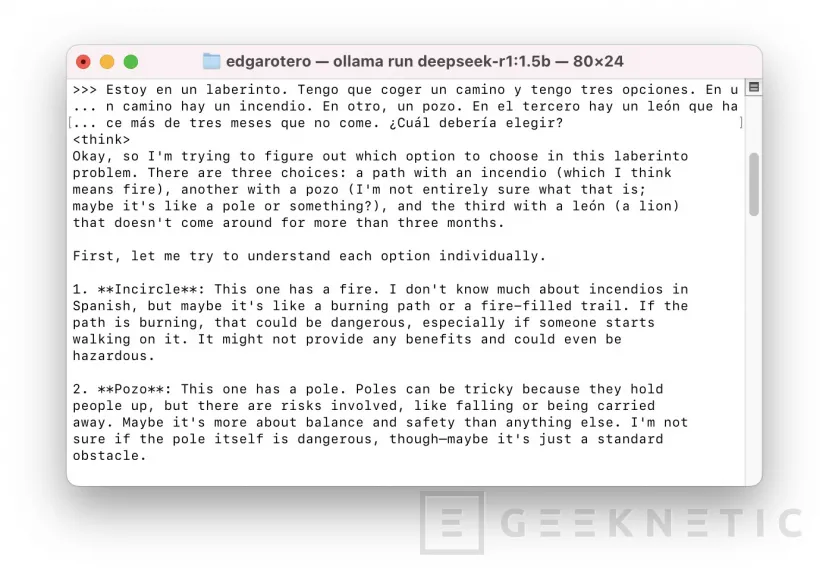

Ahora, ya lo tienes todo a punto para enviarle peticiones. Como es un modelo de razonamiento, aparece una etiqueta donde dice “think”. Todo lo que veas dentro de esa etiqueta es el razonamiento que aplica el modelo para resolver la tarea paso a paso, como si fuera un humano pensando en voz alta.

Recuerda que en Ollama tienes que usar el comando ollama run deepseek-r1 cada vez que quieras interactuar con el modelo. Lo que pasa es que solo se descarga la primera vez.

Adicionalmente, también vas a poder ejecutar DeepSeek-R1 en LM Studio, una aplicación que dispone de interfaz gráfica, pero que hace exactamente lo mismo que Ollama: ejecutar modelos de lenguaje en local.

¿Quieres saber más sobre DeepSeek? En nuestra sección de guías te explicamos cómo generar imágenes utilizando DeepSeek o cómo instalarlo en local en tu ordenador.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!