La NVIDIA HGX H100 integra 8 GPUs NVIDIA Hopper H100

por Jordi Bercial Actualizado: 23/03/2022 2 GTC 2022Hoy NVIDIA ha presentado los nuevos chips NVIDIA Hopper H100, los cuales llegan con especificaciones impresionantes, pero a fin de cuentas esto solo es la guinda del pastel, pues tal como vimos en el caso de las NVIDIA Ampere A100, NVIDIA ha utilizado estas GPUs en formatos similares, permitiéndonos hacer uso de hasta 8 GPUs NVIDIA Hopper H100 en una sola placa.

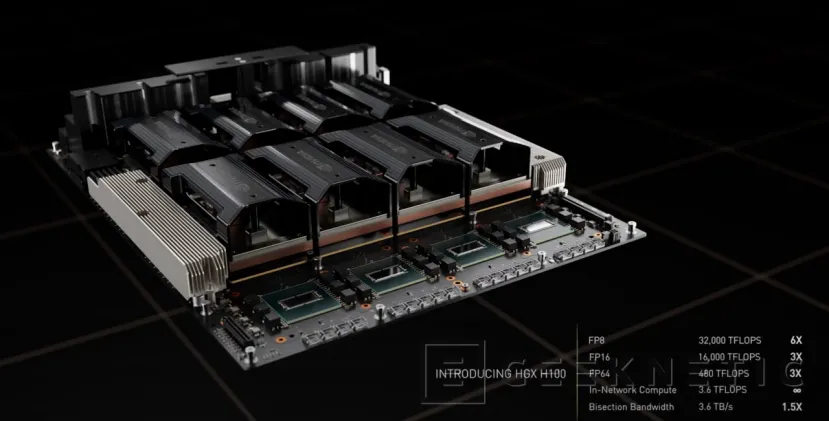

NVIDIA HGX H100

Este es el caso de la NVIDIA HGX H100, una placa en la que podemos encontrar 8 GPUs NVIDIA Hopper H100, lo cual le proporciona la friolera de 32.000 TFLOPS en FP8, así como 480 TFLOPS en FP64, cifras que no llegan precisamente solas, tal como veremos más adelante.

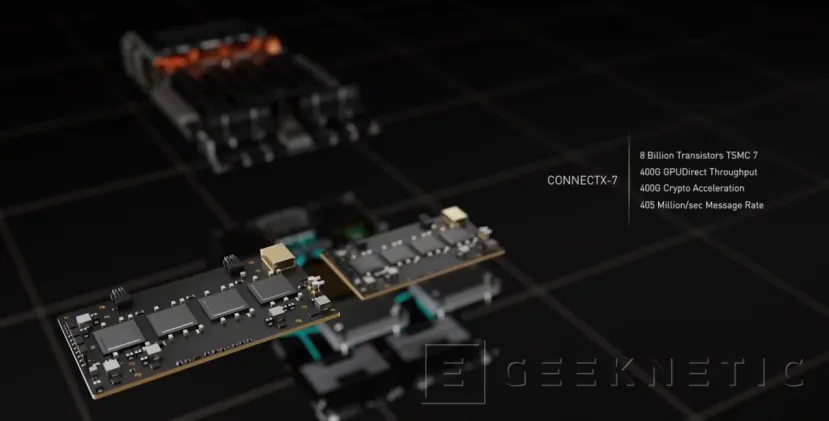

Cada una de estas placas cuenta con adaptadores de red ConnectX-7, fabricados a 7 nanómetros, que les permiten comunicarse mediante Infiniband a velocidades de 400Gbps, por lo que conectar estas placas entre sí, así como a otros sistemas como serían cabinas de almacenamiento de datos será relativamente sencillo.

NVIDIA DGX H100

Sin embargo, la joya de la corona es el empaquetado en el que encontraremos la mayoría de HGX H100, y se trata de los NVIDIA DGX H100, unos equipos en los que encontraremos 8 GPUs H100 emparejadas con 640GB de memoria HBM3, 32PFLOPS de rendimiento de inteligencia artificial –es decir, los 32.000 TFLOPS en FP8 que mencionábamos antes— y hasta 24TB/s de ancho de banda de memoria, algo crítico para operaciones de inteligencia artificial.

Estos equipos podrán combinarse en lo que NVIDIA conoce como Pods, los cuales en sus configuraciones con GPUs NVIDIA H100 contarán con un rendimiento de 1EFLOPS en rendimiento de inteligencia artificial, entrando así por todo lo alto en la exaescala al combinar 32 equipos NVIDIA DGX H100.

Asimismo, esto se conseguirá gracias a 20TB de memoria HBM3, 192TFLOPS de capacidad de cómputo SHARP, y 70TB/s de ancho de banda biseccional. Esta no es la forma final de estos equipos, pues tal como veremos más adelante, lo que NVIDIA conoce como EOS es un sistema diseñado para llenar un centro de datos por sí sólo, proporcionando así espectaculares cifras de rendimiento.

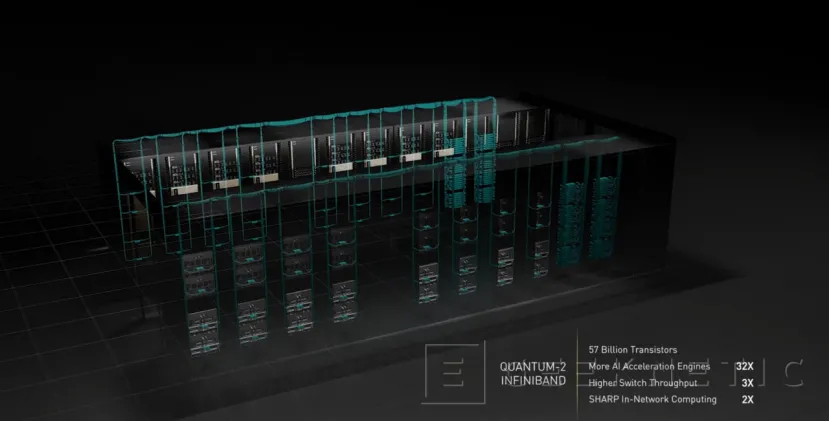

NVIDIA EOS

NVIDIA EOS es la combinación de 18 Pods equipados con 32 equipos NVIDIA DGX H100. Esto permitirá a los clientes de NVIDIA contar con un centro de datos en el que contaremos con una potencia máxima de 18 ExaFLOPS de cómputo FP8, usado para inteligencia artificial, así como 275PFLOPS en FP64.

Su capacidad de cómputo dentro de la propia red es de 3.7PFLOPS, ahorrando así una gran cantidad de ciclos de CPU que podrían ser muy valiosos en otras tareas, mientras que con un ancho de banda biseccional de 230TB/s entre servidores, cualquier dato necesario llegará a los Pods que lo requieran en cuestión de fracciones de segundo, reduciendo así toda la latencia posible en cuanto a adquisición de datos para procesar.

Gracias a estos nuevos avances obtenidos con las GPUs NVIDIA Hopper H100, existen cargas de trabajo que podrán hacerse en una fracción del tiempo que requerían hasta ahora. Por ejemplo, NVIDIA muestra como el entrenamiento de una red neuronal GPT-3 puede hacerse en tan solo 19 horas con el uso de 20.000 GPUs NVIDIA H100, en comparación a los 5 días que se tardaría con el uso del mismo número de GPUs NVIDIA A100.

El entrenamiento de una red Mixture of Experts también pasaría de 7 días a 20 horas con el uso de 8000GPUs Hopper, mientras que la latencia del Chatbot Megatrion 530B pasaría a reducirse hasta a un segundo, permitiendo así que las conversaciones con este tipo de chatbots sean mucho más rápidas y eficientes en varios escenarios.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!