Samsung firma un acuerdo con AMD para producir memoria HBM3E para sus aceleradores de Inteligencia Artificial

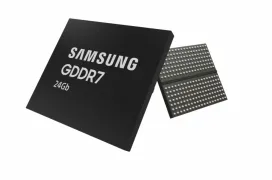

por Juan Antonio SotoAntes de comenzar con la próxima memoria HBM4, los fabricantes están produciendo en masa la actual y más rápida HBM3E que se empleará en las soluciones actuales para acelerar las cargas de inteligencia artificial. AMD utilizará la memoria HBM3E de Samsung 12H (12 capas de altura) en un acuerdo que han firmado ambas compañías por valor de 4,134 billones de wones, algo más de 2.800 millones de euros.

Parece que el acuerdo incluye la compra de GPU de AMD por parte de Samsung, a cambio de esta última suministrar memoria HBM3E a AMD. AMD lanzará la aceleradora MI350X con memoria HBM3E para la segunda mitad de este año que podrá llevar hasta 288 GB de memoria, tal y como se ha visto que introducirá la NVIDIA B200 basada en Blackwell. Se dice que AMD lanzará esta nueva aceleradora MI350X durante la segunda mitad de este 2024 con este nuevo tipo de memoria de Samsung y que podrá ofrecer mayor cantidad de memoria gracias a sus 12 capas.

Debido al impulso de la Inteligencia Artificial, los fabricantes están introduciendo modelos cada vez más capaces y con mayor rendimiento para este tipo de tareas. Una solución ideal es añadir esta memoria de alto ancho de banda, donde los fabricantes de memoria cada vez ofrecen mayores velocidades y capacidad en un mismo chip ideales para este tipo de tareas.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!