NVIDIA G-Sync, la solución a los problemas de sincronización entre gráfica y pantalla

por Antonio Delgado 20

Actualmente el monitor y la gráfica son dispositivos separados sin ningún tipo de conexión que los sincronice más que la emisión de vídeo hacia el monitor, que dependiendo de la tasa de refresco que tenga, actualizará la pantalla para mostrar la imagen. Esto provoca los conocidos problemas de tearing y stuttering y entrecortes en la imagen al actualizarse la pantalla mientras se envía un nuevo frame desde la GPU, algo bastante molesto en los juegos. Para solucionarlo tenemos el vSYNC que sincroniza la tasa de imágenes por segundo generada por la gráfica con la tasa de refresco de la pantalla. El problema de esta tecnología es que limita a los FPS o imágenes por segundo correspondientes a los Hz de la pantalla, si tenemos un monitor de 60 Hz, tendremos un máximo de 60 FPS. Además, si nuestro equipo no es capaz de mantener los 60 FPS, el problema se mantiene

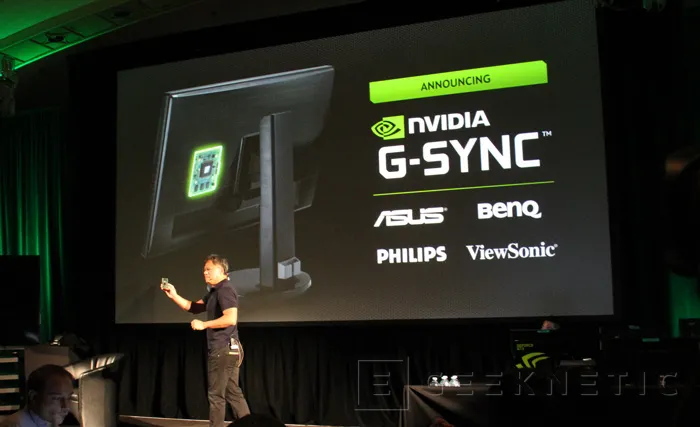

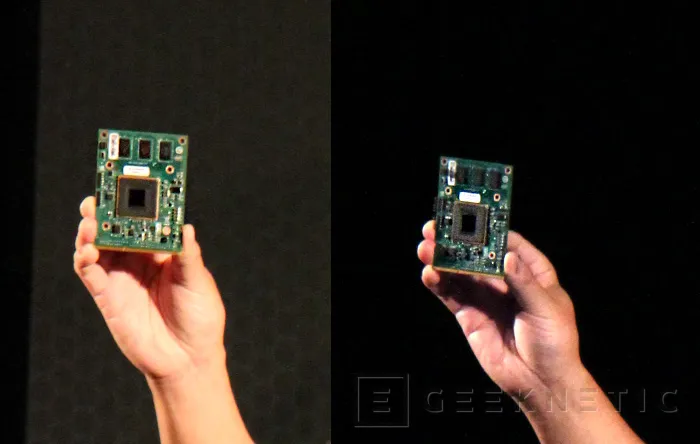

Para solucionar esto, NVIDIA ha presentado G-Sync, una tecnología que sincroniza el monitor con la gráfica para tener una imagen perfecta sin estos problemas antes mencionados, para ello ambos dispositivos tienen que estar perfectamente sincronizados y es necesario un chip integrado en el monitor, llamado Módulo G-Sync.

Será compatible con las gráficas de arquitectura Kepler de Nvidia, haciendo que los tiempos de sincronización se controlen desde la propia GPU en vez de basarse en los HZ de la pantalla, de tal manera que primero se genera la imagen, se envía al monitor y este actualiza lo mostrado por pantalla con una imagen correcta, de este modo siempre se conseguirá que el monitor muestre los juegos sin ningún tipo de problema de sincronización como el tearing, retrasos en la imagen o el stuttering.

Los primeros fabricantes que lanzarán al mercado monitores con NVIDIA G-Sync serán ASUS, BenQ, Philips y ViewSonic, aunque se espera que otros fabricantes empiecen a integrarlo paulatinamente.

Hemos podido ver en directo las demos que ha mostrado Nvidia con un equipo con G-Sync y otro sin el y la diferencia es apreciable a simple vista, naturalmente en el test preparado específicamente la diferencia es más apreciable, pero hemos podido ver el nuevo Tomb Raider y es innegable que se nota perfectamente la diferencia.

Podremos jugar con cifras por debajo de los 60 FPS y conseguir un vídeo fluido y sin problemas de sincronización, de la misma manera, si nuestra gráfica es capaz de generar más FPS que la frecuencia de actualización de la pantalla, se sincronizará automáticamente. En ambos casos se consigue una experiencia de juego impresionante, que nos hace preguntarnos por qué no se ha intentado solucionar este problema hace años.

Estará disponible el chip G-Sync durante el primer trimestre del año 2014 integrado en monitores de distinto tamaño, con distintas resoluciones e incluso tasa de refresco. La diferencia respecto al mismo monitor sin G-Sync será de un ligero aumento de precio que no afectará al precio habitual de los monitores dentro de su gama y características. En el momento de la salida al mercado de los primeros monitores se lanzará el driver para las tarjetas gráficas con arquitectura Kepler de Nvidia.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!